Пользователь соцсети X под ником Alex Prompter опубликовал 14 января утекшие внутренние документы OpenAI с сенсационным заявлением: Илья Суцкевер (Ilya Sutskever) — один из основателей компании и бывший главный научный сотрудник — якобы доказал физическую невозможность создания искусственного общего интеллекта.

Суцкевер считается одним из ведущих специалистов по нейронным сетям в мире. Он участвовал в создании GPT и был ключевой фигурой в развитии ChatGPT. В мае 2024 года он покинул OpenAI для создания собственной компании Safe Superintelligence, посвященной безопасной разработке ИИ.

AGI (Artificial General Intelligence) — это гипотетическая система искусственного интеллекта, способная выполнять любые интеллектуальные задачи на уровне человека или превосходить его. В отличие от современных узкоспециализированных алгоритмов вроде ChatGPT или системы распознавания изображений, AGI должен обладать универсальными когнитивными способностями.

Принцип Ландауэра: почему забывание стоит энергии

Основа спекуляций — принцип Ландауэра, открытый физиком IBM Рольфом Ландауэром в 1961 году. Этот закон связывает информацию с физикой и устанавливает минимальную энергетическую цену за стирание данных.

Представьте компьютерную память как набор переключателей, каждый из которых может находиться в положении «0» или «1». Когда мы стираем бит информации — например, принудительно устанавливаем его в «0» независимо от предыдущего состояния — мы физически уничтожаем различие между этими двумя состояниями.

Согласно второму закону термодинамики, общая энтропия (мера беспорядка) во Вселенной никогда не может уменьшаться. Стирание бита уменьшает энтропию в компьютере, поэтому для сохранения баланса энтропия окружающей среды должна увеличиться. Это увеличение происходит через выделение тепла.

Минимальная энергия стирания описывается формулой E ≥ kT ln 2, где k — постоянная Больцмана (1,38×10-23 Дж/К), T — температура в кельвинах, а ln 2 ≈ 0,693 — натуральный логарифм двойки. При комнатной температуре (300К) это составляет ничтожные 2,9×10-21 Дж на бит — в миллион миллиардов раз меньше энергии, необходимой для подъема пылинки на миллиметр.

Критически важно: принцип действует только для необратимых операций стирания информации. Логически обратимые операции, где каждому входу соответствует уникальный выход, теоретически могут выполняться без энергозатрат.

От микроватт к энергии Солнечной системы

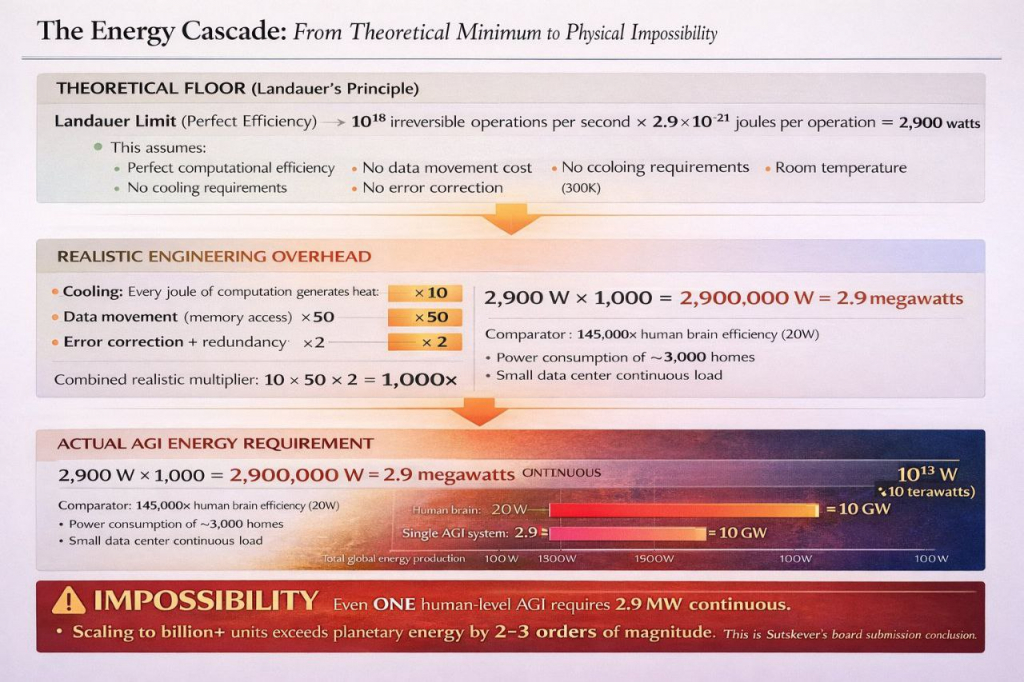

В приложенных к публикации профессионально оформленных слайдах утверждается, что AGI потребует 1018 необратимых операций в секунду. Умножив на энергию Ландауэра, авторы получают теоретический минимум 2900 Вт — в 145 раз больше энергопотребления человеческого мозга.

Затем «расчеты» усложняются. С учетом реальных инженерных ограничений — охлаждения (увеличивает потребление в 10 раз), передачи данных между процессором и памятью (в 50 раз), коррекции ошибок (в 2 раза) — авторы фейка получают 2,9 МВт для одной системы AGI. Это энергопотребление небольшого города для имитации одного человеческого интеллекта.

Но главная «бомба» — в масштабировании. Согласно поддельным документам, для обслуживания всего человечества потребуются миллиарды систем AGI. Авторы утверждают, что это приведет к энергопотреблению 1021 Вт — в миллион раз больше всей энергии, производимой человечеством, и якобы превышает энергетические ресурсы всей Солнечной системы.

Подозрительно качественная подделка

К публикации приложены профессионально выглядящие документы: презентации с графиками, якобы внутренняя переписка совета директоров OpenAI, скриншоты из Slack с обсуждениями руководства. В «документах» утверждается, что Сэм Альтман (Sam Altman) признавал правоту расчетов Суцкевера, но называл их «технически верными, но стратегически неуместными».

Поддельные материалы включают даже детализированную хронологию якобы произошедшего в ноябре 2023 года кризиса в совете директоров OpenAI из-за термодинамических ограничений. Качество подделки выдает её искусственное происхождение: слишком много штампов «CONFIDENTIAL», профессиональный дизайн презентаций и правдоподобные, но сфабрикованные внутренние переписки.

Научная критика

Заявления Alex Prompter немедленно вызвали критику экспертов. Аналитик Roko назвал идею о невозможности AGI «самой идиотской вещью об ИИ, которую когда-либо читал».

Специалист TokyoL7G объяснил фундаментальную ошибку: «Человеческий мозг работает при мощности около 20 Вт. Не потому, что он нарушает термодинамику, а потому, что представляет собой чрезвычайно эффективную асинхронную систему».

Эксперт 9DATTM указал на методологические ошибки: неправомерное приравнивание предела Ландауэра к требованиям интеллекта, игнорирование алгоритмического сжатия и возможности энергоэффективных обратимых вычислений.

Реальность энергопотребления ИИ

Современные системы ИИ действительно требуют колоссальных энергозатрат, но это связано с несовершенством существующих технологий, а не с фундаментальными физическими ограничениями. Обучение GPT-3 потребовало около 1300 МВт·ч, дата-центры для ИИ расходуют мегаватты постоянно — это энергопотребление целых городов.

Однако человеческий мозг доказывает возможность высокоэффективных вычислений: 86 млрд нейронов, обрабатывающих сложнейшую информацию при потреблении всего 20 Вт. Принцип Ландауэра не препятствует созданию энергоэффективных архитектур — он лишь устанавливает теоретический минимум для необратимых операций стирания.

Отсутствие подтверждений

Ни Илья Суцкевер, ни OpenAI не подтверждали существование подобных исследований. Публичные высказывания Суцкевера от мая 2024 года выражают уверенность в достижимости AGI с акцентом на безопасность. Сайт его новой компании Safe Superintelligence фокусируется на создании безопасного ИИ без упоминаний термодинамических барьеров.

Представленные материалы — изощренная дезинформация, основанная на неточном применении физических принципов и экстраполяции сомнительных допущений до абсурда. Подделка демонстрирует растущую изощренность фальшивых утечек в эпоху ИИ, но научное сообщество единодушно отвергает подобные псевдонаучные спекуляции о энергетической невозможности создания эффективного искусственного интеллекта.

Мнение ИИ

Анализ исторических паттернов дезинформации показывает интересную закономерность: самые эффектные научные фейки всегда эксплуатируют реальные физические принципы. Холодный синтез 1989 года тоже базировался на настоящих ядерных реакциях, но с фальшивыми данными. Принцип Ландауэра здесь играет роль идеального «крючка» — он достаточно сложен, чтобы большинство не могли его проверить, но достаточно фундаментален, чтобы звучать убедительно.

Макроэкономический контекст создания подобных фейков заслуживает внимания. Индустрия ИИ переживает период максимальных инвестиций и ожиданий — классическую фазу пузыря, когда любые сомнения в технологической достижимости могут обвалить миллиардные вложения. Такая информационная атака потенциально способна повлиять на биржевые котировки технологических гигантов. Остается вопрос: кому выгодно подрывать веру в AGI именно сейчас?

▼

Самые интересные и важные новости на нашем канале в Telegram